一文了解 caffe 框架 | CSDN 博文精选

作者 |Javier Casas Velasco译者 |弯月,责编 | 屠敏出品 | CSDN(ID:CSDNnews)什么是caffeCaffe 全称:Convol...

作者 | Javier Casas Velasco

译者 | 弯月,责编 | 屠敏

出品 | CSDN(ID:CSDNnews)

什么是caffe

Caffe 全称:Convolution Architecture For Feature Extraction(用于特征抽取的卷积框架)。

Caffe是一个清晰、可读性高、快速的深度学习框架。

Caffe前身是decaf,由加州伯克利大学博士贾扬青开发的一个用于深度卷积网络的Python框架(无GPU)模式,之后被伯克利大学实验室团队丰富成caffe。

Caffe的特点

Expression:通过文本来构建模型和优化策略,而不是代码。

Speed:现有的CNN模型中速度最快。在NVIDIA K40 或Titan GPU*上,训练一张图片要5ms,测试一张图片要2ms。

Modularity:易扩展

纯C++/CUDA构建的框架,提供了命令行、Python、MATLAB接口

实现了CPU和GPU的无缝结合

Caffe Model Zoo :model share

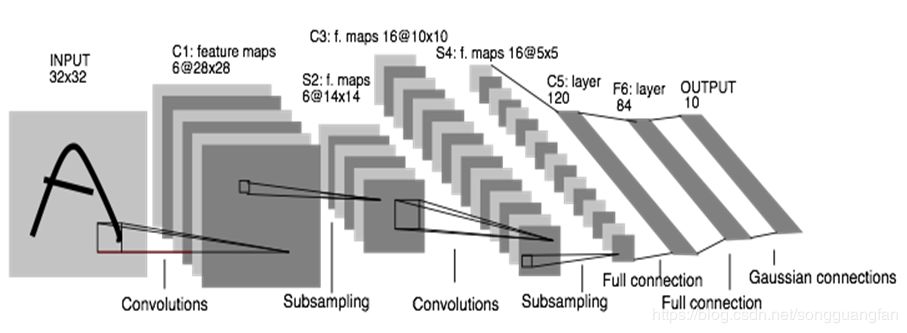

CNN框架:LeNet

1998年LeCun 提出的用于手写字体的卷积神经网络。

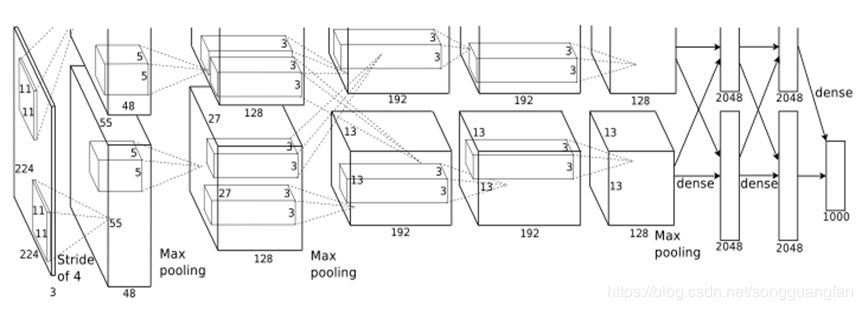

CNN框架:AlexNet

AlexNet :2012年Hinton教授和其他学生Alex Krizhevsky, llya Sutskever提出的用于图像识别的CNN框架。

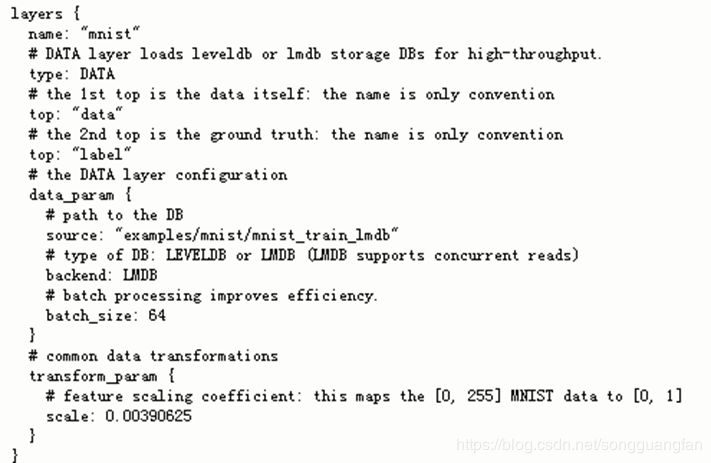

数据层(data_layer)

caffe 通过数据层获取数据。数据的来源可以是多种形式。例如:

LevelDB,LMDB(两种键值对嵌入式数据库管理系统编程库,一般LMDB比LevelDB存取速度快,所以caffe默认的事LMDB)

直接从内存读取

HDF5文件

原始图片

类 data_layer.hpp/data_layer.cpp

在定义网络的prototxt 文件中可以定义数据层的形式,比如手写字体数据层定义如下:

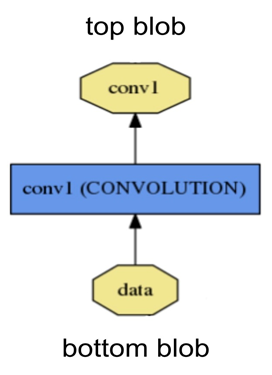

数据传递(blob)

caffe框架中数据是以blob的形式进行传递

blob是一个标准的数组,主要负责caffe中数据的存储(store),关联(communicate)。数据在网络结构中要经过正向和反向的传播的过程,在这个过程中要对数据进行存储、数据之间进行通信、以及数据的操作。blob就是负责这个过程。

在具体的形式上blob是回一个4-D结构的array,是按照(Num, Channels. Height, Width)的顺序存储的。

Nums:表示一次训练输入的图片数量

Channels:表示通道数

Height:表示图片高度

Width:表示图片的宽度

实际上blob 是存储的数据在内存中的索引,比如index(n,k,h,w)定位在((n*k + k)*H + h)*W+w。示意图如下:

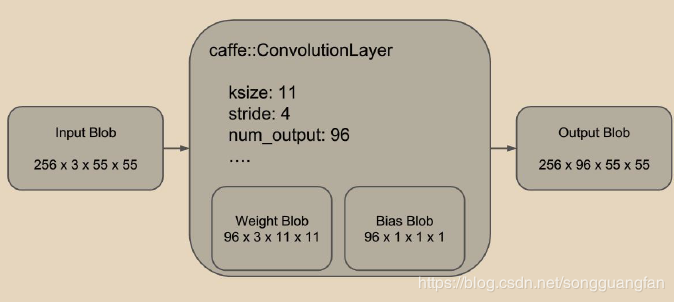

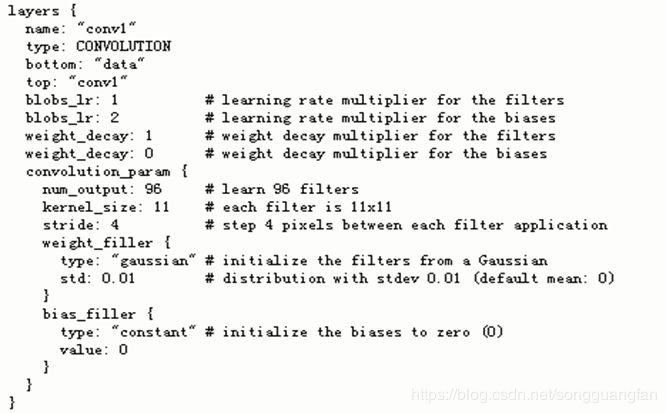

卷积层(convolution)

卷积层定义了图像的卷积操作(即特征抽象),参数设置在prototxt中 ,它相关的类定义在conv_layer.cpp。

例如用到的一个卷积:

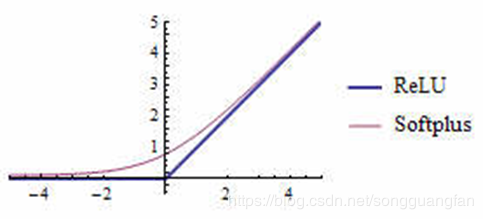

受限线性单元(RELU)

RELU的全称:rectified linear units。

受限线性单元实际上就是激活函数max(0,x), 它的相关类定义在relu_layer.cpp中。

相比之下,ReLU的速度非常快,而且精准度更高。因此ReLU逐渐取代sigmoid成为主流

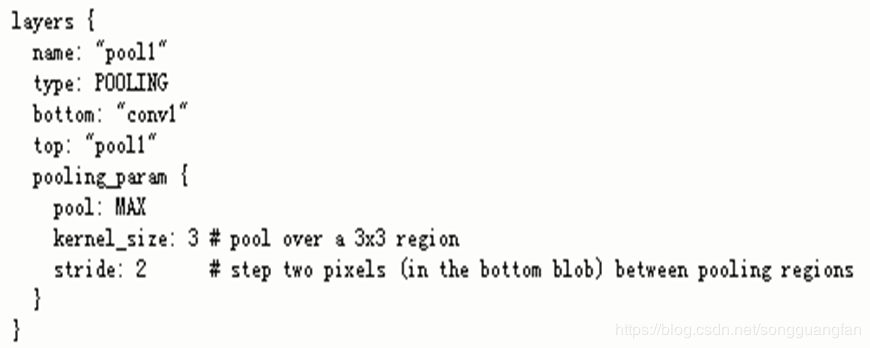

池化层(POOLING)

池化层定义了对对象的降维操作。它的相关类定义在pooling_layer.cpp。参数设置prototxt中。

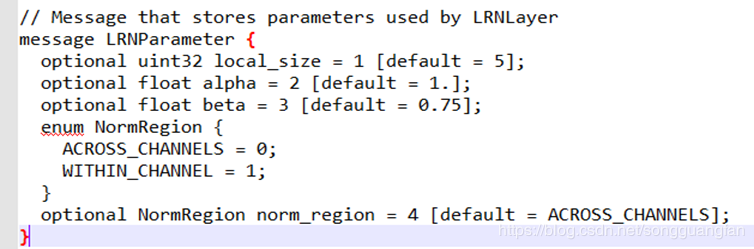

局部响应归一化层(LRN)

LRN全称是Local Response Normalization,相关的类定义在lrn_layer.cpp中,其参数定义在prototxt中。局部响应归一化层完成一种“临近抑制”操作,对局部输入区域进行归一化。本质上是防止激活函数饱和,能提升网络的泛化能力,将错误率降低。

local_size:两种表示

通道间归一化时表示求和的通道数

通道内归一化时表示求和区间的边长;默认值为5

alpha:缩放因子,默认值为1

beta:指数项,默认值为1

NormRegion:选择对相邻通道间归一化or通道内空间区域归一化,默认为ACROSS_CHANNELS。

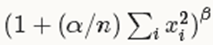

在通道间归一化模式中,局部区域范围在相邻通道间,但没有空间扩展(即尺寸为local_size11);在通道内归一化模式中,局部区域在空间上扩展,但只针对独立通道进行(即尺寸为1local_sizelocal_size);每个输入值都将除以

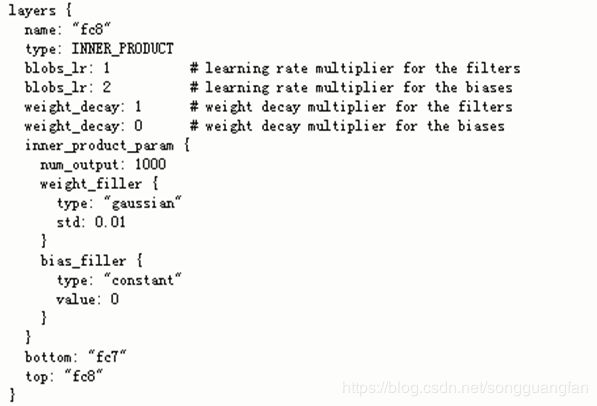

全连接层(INNER_PRODUCT)

全连接层相关的类定义在inner_product_layer.cpp中,输出特征都是1*1的特征,参数定义在prototxt中。

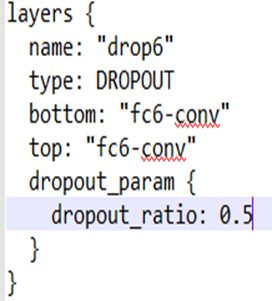

Dropout层

Dropout层的相关类定义在dropout.cpp中,它的作用是防止过拟合和降低计算复杂度。

在实际训练中,每个节点都以相互独立的以p概率出现,实验证明p=0.5时在大规模网络中效果最优。

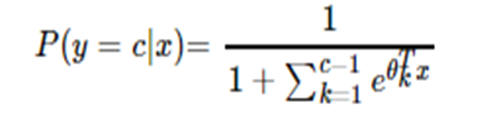

输出(分类)层(softmax)

相关类定义在softmax_lay,cpp中:

声明:本文为 CSDN 博主「.NY&XX」的原创文章,版权归作者所有,如需转载,请联系作者。

原文:https://blog.csdn.net/songguangfan/article/details/99436777

【END】

热 文 推 荐

☞阿里拟 20 亿美元收购网易考拉;联通 5G 套餐最低 190 元;Rust 1.37.0 发布 | 极客头条

![]() 点击阅读原文,输入关键词,即可搜索您想要的 CSDN 文章。

点击阅读原文,输入关键词,即可搜索您想要的 CSDN 文章。

你点的每个“在看”,我都认真当成了喜欢

更多推荐

已为社区贡献12387条内容

已为社区贡献12387条内容

所有评论(0)