对手来了!亚马逊生成式 AI 比 GPT-3.5 更好

作者 | NIVASH JEEVANANDAM译者| 禾木木出品 | CSDN(ID:CSDNnews)技术圈很久都没有这么热闹了,要问大家当下都在热聊什么,非 ChatGPT 莫属了,一举成为 Stable Diffusion 之外的 AI 新宠。网友也特别乐于「调戏」它,还生成出了不少奇怪的神回复。OpenAI 在两个多月前向公众推出了 ChatGPT,立即将 AI 驱动的聊天...

作者 | NIVASH JEEVANANDAM 译者 | 禾木木

出品 | CSDN(ID:CSDNnews)

技术圈很久都没有这么热闹了,要问大家当下都在热聊什么,非 ChatGPT 莫属了,一举成为 Stable Diffusion 之外的 AI 新宠。

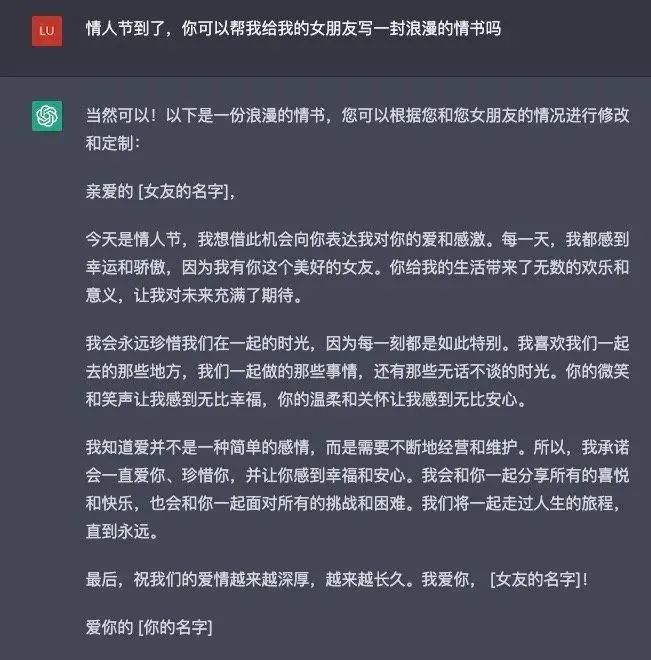

网友也特别乐于「调戏」它,还生成出了不少奇怪的神回复。

OpenAI 在两个多月前向公众推出了 ChatGPT,立即将 AI 驱动的聊天机器人推到了主流讨论中心,人们都在讨论它如何改变商业、教育等领域。

近日,在 ScienceQA 基准测试中,研究人员表明:亚马逊的新语言模型比 GPT-3.5 高出 16 个百分点(75.17%),甚至超过了许多人类。

注:ScienceQA 基准测试是一组带有注释答案的大型多模态科学问题集。它有超过 21,000 道多模态选择题(MCQs)。

技术的进步使大型语言模型(LLMs)能够很好地完成复杂推理的任务。这是通过思维链(CoT)的提示来实现的,思维链是发展中间步骤的意义,以显示如何做某事的过程。

但目前大多数关于 CoT 的工作只关注语言模式,研究人员经常使用多模态 CoT 范式来寻找多模态 CoT 推理。而多模态更依赖于视觉和语言等多种输入。

它是如何工作?

多模态 CoT 将多个步骤的问题分解为中间推理过程,即使输入来自语言和视觉等不同模态,从而都能得出最终答案。

进行多模态 CoT 最常见的方法之一是在要求 LLM 做 CoT 之前,将来自多种模态的信息合并为单一的模态。

但这种方法有一些问题,其中之一是将数据从一种格式转移到另一种格式时,会丢失很多信息。通过结合语言和视觉的不同方面,微调小型语言模型也可以在多模态中进行 CoT 推理。

然而,这种方法的主要问题是,这些语言模型有产生幻觉的推理模式的倾向,大大影响了答案推理。

亚马逊的研究人员提出了 Multimodal-CoT,它将视觉特征结合在一个单独的训练框架中,以减少这些错误的影响。该框架将推理过程分为两部分:寻找原因和找出答案。该模型通过将视觉纳入两个阶段,提出了更有说服力的论点。此外,它还有助于对答案得出更准确的结论。这是第一个研究 CoT 推理工作方式不同的同类作品。在 ScienceQA 基准测试中,亚马逊研究人员提供的这项技术展示了最先进的性能,比 GPT-3.5 精度高出 16 个百分点,超过了人类的表现。

它的表现如何?

多模态答案 CoT 的推理和推理生成阶段都使用相同的模型架构,但在输入和输出上有所不同。例如,在视觉语言模型的基本原理生成阶段,模型从视觉和语言领域获得数据。然后,一旦做出了基本原理,就会将其添加到答案推理步骤中的初始语言输入中,以便为下一阶段的语言输入。

简单地说,该语言的文本被放入Transformer 编码器中以形成文本表示。然后,将这些文本和视觉表示放在一起,并输入 Transformer 解码器。

评价

为了了解他们的方法如何运作,研究人员对 ScienceQA 进行了许多测试。得出结论,他们的方法在基准测试上比之前最先进的 GPT-3.5 模型高出16%。

简而言之,亚马逊的研究人员通过提出一个将视觉和语言表示与运行 Multimodal-CoT 相结合的两阶段框架,研究并解决了激发多模态 CoT 推理的问题。

因此,该模型提供了实际的理由来帮助找出最终的答案。

结论

亚马逊的研究人员在他们的研究中证明,使用视觉特征有助于开发更有效的推理,这有助于更准确的答案推理。

使用多模态 CoT,他们证明了 1B 模型在 ScienceQA 基准测试中的表现比 GPT-3.5 要高出 16%。他们的错误分析表明,在未来的研究中,有可能利用更有效的视觉特征,注入常识性信息,并应用过滤过程来改善 CoT 推理。

目前,行业巨头们已经逐渐在研究建立一个聊天机器人发展的标准,亚马逊现在也加入了这场竞争中。无论是国内外,这场竞争无疑将引领聊天机器人最佳解决方案和产品的发展方向,让我们拭目以待未来会有哪些精彩的事情。

参考链接:

https://www.moneycontrol.com/news/technology/chatgpt-competitors-amazon-jumps-into-fray-with-generative-ai-better-than-gpt-3-5-10063651.html/amp

☞马斯克:若竞品够好,我不介意特斯拉破产

☞火山引擎DataTester:A/B测试,让企业摆脱广告投放“乱烧钱”

☞低成本复制 ChatGPT 训练流程,仅需 1.68GB GPU 即可使用,方法现已开源!更多推荐

已为社区贡献12380条内容

已为社区贡献12380条内容

所有评论(0)